Главная страница Случайная страница

Разделы сайта

АвтомобилиАстрономияБиологияГеографияДом и садДругие языкиДругоеИнформатикаИсторияКультураЛитератураЛогикаМатематикаМедицинаМеталлургияМеханикаОбразованиеОхрана трудаПедагогикаПолитикаПравоПсихологияРелигияРиторикаСоциологияСпортСтроительствоТехнологияТуризмФизикаФилософияФинансыХимияЧерчениеЭкологияЭкономикаЭлектроника

Краткие теоретические сведения. Нейронные сети – это класс аналитических методов, построенных на принципах функционирования мозга и позволяющих прогнозировать значения некоторых переменных в

|

|

Нейронные сети – это класс аналитических методов, построенных на принципах функционирования мозга и позволяющих прогнозировать значения некоторых переменных в новых наблюдениях по данным других наблюдений, после прохождения этапа обучения на имеющихся данных.

Искусственным нейроном (рис. 5.1) называется простой элемент, сначала вычисляющий взвешенную сумму V входных величин xi:

.

.

Здесь N – размерность пространства входных сигналов.

| Рис. 5.1. Искусственный нейрон |

Затем полученная сумма сравнивается с пороговой величиной W 0, вслед за чем вступает в действие нелинейная функция активации f. Коэффициенты { Wi } во взвешенной сумме обычно называют синаптическими коэффициентами или весами. Саму же взвешенную сумму V называют потенциалом нейрона i. Выходной сигнал тогда имеет вид f (V).

Величину порогового барьера можно рассматривать как еще один весовой коэффициент при постоянном входном сигнале. В этом случае мы говорим о расширенном входном пространстве: нейрон с N -мерным входом имеет N +1 весовой коэффициент. Если ввести в уравнение пороговую величину W 0, то оно перепишется так:

.

.

В зависимости от способа преобразования сигнала и характера активации возникают различные виды нейронных структур. Существуют детерминированные нейроны, когда активизирующая функция однозначно вычисляет выход по входу, и вероятностные нейроны, состояние которых в момент t есть случайная функция потенциала и состояния в момент (t –1).

В искусственных нейронах могут быть различные функции активации:

- линейная, выходной сигнал нейрона равен его потенциалу;

- пороговая, нейрон выбирает решение из двух вариантов – активен / неактивен;

- многопороговая, выходной сигнал может принимать одно из значений q, определяемых (q –1) порогом внутри предельных значений;

- сигмоидная, рассматриваются два вида сигмоидных функций:

– с выходными значениями в промежутке [0, 1];

– с выходными значениями в промежутке [0, 1];

– с выходными значениями в промежутке [-1, 1].

– с выходными значениями в промежутке [-1, 1].

Коэффициент b определяет крутизну сигмоида. Поскольку сигмоидная функция является гладким отображением (-¥, ¥) на (-1, 1), то крутизну можно учесть через величины весов и порогов, и без ограничения общности можно полагать ее равной единице.

Из точек на плоскости и соединений между ними можно построить множество графических фигур, называемых графами. Если каждую точку представить себе как один нейрон, а соединения между точками – как дендриты и синапсы, то мы получим нейронную сеть. Но не всякое соединение нейронов будет работоспособно или вообще целесообразно. Поэтому на сегодняшний день существует только несколько работающих и реализованных программно архитектур нейросетей.

По архитектуре связей нейросети могут быть сгруппированы в два класса: сети прямого распространения, в которых связи не имеют петель (рис. 5.2), и сети рекуррентного типа, в которых возможны обратные связи (рис. 5.3).

| Рис. 5.2. Сеть прямого распространении | Рис. 5.3. Рекуррентная сеть |

Сети прямого распространения подразделяются на однослойные перцептроны (сети) и многослойные перцептроны (сети). Рассмотрим устройство простейшей многослойной нейросети. Любая нейронная сеть состоит из входного слоя и выходного слоя. Соответственно подаются независимые и зависимые переменные. Входные данные преобразуются нейронами сети и сравниваются с выходом. Если отклонение больше заданного, то специальным образом изменяются веса связей нейронов между собой и пороговые значения нейронов. Снова происходит процесс вычислений выходного значения и его сравнение с эталоном. Если отклонения меньше заданной погрешности, то процесс обучения прекращается.

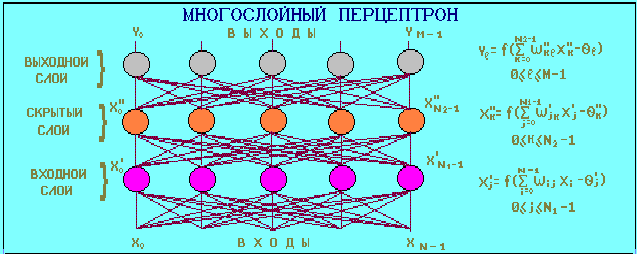

Помимо входного и выходного слоев в многослойной сети существуют так называемые скрытые слои. Они представляют собой нейроны, которые не имеют непосредственных входов исходных данных, а связаны только с выходами входного слоя и с входом выходного слоя. Таким образом, скрытые слои дополнительно преобразуют информацию и добавляют нелинейности в модели. Устройство многослойного перцептрона приведено на рис. 5.4.

|

| Рис. 5.4. Многослойный перцептрон |

Если однослойная нейросеть очень хорошо справляется с задачами классификации, так как выходной слой нейронов сравнивает полученные от предыдущего слоя значения с порогом и выдает значение либо ноль, то есть меньше порогового значения, либо единицу больше порогового (для случая пороговой внутренней функции нейрона), и не способен решать большинство практических задач, то многослойный перцептрон с сигмоидными решающими функциями способен аппроксимировать любую функциональную зависимость (это было доказано в виде теоремы). Но при этом не известно ни нужное число слоев, ни нужное количество скрытых нейронов, ни необходимое для обучения сети время.

Поведение рекуррентных сетей описывается дифференциальными или разностными уравнениями, как правило, первого порядка. Это гораздо расширяет области применения нейросетей и способы их обучения. Сеть организована так, что каждый нейрон получает входную информацию от других нейронов, возможно, и от самого себя, и от окружающей среды. С их помощью этого типа сетей можно моделировать нелинейные динамические системы.

Среди рекуррентных сетей можно выделить сети Хопфилда и сети Кохонена.

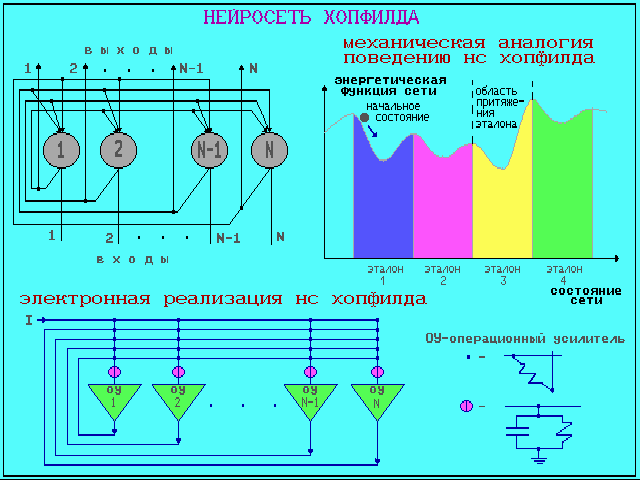

Сеть Хопфилда построена из N нейронов, которые образуют прямоугольную решетку на плоскости.

Нейросеть Хопфилда можно использовать в качестве ассоциативной памяти. Архитектура сети Хопфилда изображена на рис. 5.5.

|

| Рис. 5.5. Нейросеть Хопфилда |

Сеть Кохонена еще называют «самоорганизующейся картой признаков». Сеть такого типа рассчитана на самостоятельное обучение во время обучения, сообщать ей правильные ответы необязательно. В процессе обучения на вход сети подаются различные образцы. Сеть улавливает особенности их структуры и разделяет образцы на кластеры, а уже обученная сеть относит каждый вновь поступающий пример к одному из кластеров, руководствуясь некоторым критерием «близости».

Сеть состоит из одного входного и одного выходного слоя. Количество элементов в выходном слое непосредственно определяет, сколько различных кластеров сеть сможет распознать. Каждый из выходных элементов получает на вход весь входной вектор. Как и во всякой нейронной сети, каждой связи приписан некоторый синоптический вес.

Главное отличие и преимущество нейросетей перед классическими средствами прогнозирования и классификации заключается в их способности к обучению.

На этапе обучения происходит вычисление синоптических коэффициентов в процессе решения нейронной сетью задач.

Для обучения нейронной сети требуются обучающие данные. Они должны отвечать свойствам представительности и случайности или последовательности. Все зависит от класса решаемой задачи. Действия, которые при этом происходят, можно назвать контролируемым обучением. Контролируемое обучение нейросети можно рассматривать как решение оптимизационной задачи. Ее целью является минимизация функции ошибок Е на данном множестве примеров путем выбора значений весов W. Достижение минимума называется сходимостью процесса обучения. Обычно в качестве меры погрешности берется средняя квадратичная ошибка (СКО):

,

,

где М – число примеров в обучающем множестве.

Минимизация величины Е осуществляется с помощью градиентных методов. Изменение весов происходит в направлении, обратном к направлению наибольшей крутизны для функции:

.

.

Здесь e – определяемый пользователем параметр, который называется коэффициентом обучения.

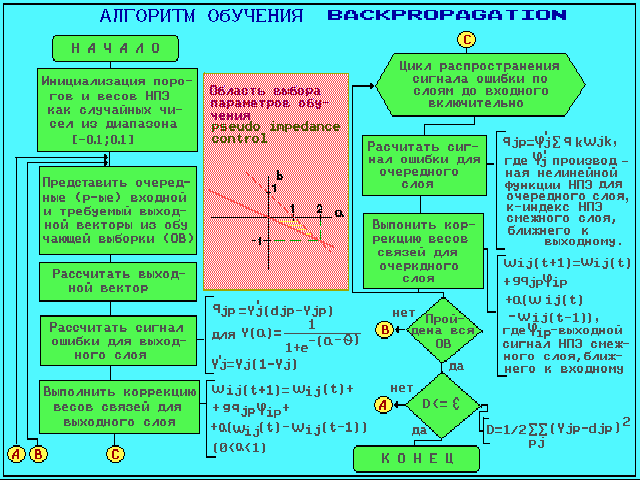

Одним из самых распространенных алгоритмов обучения нейросетей прямого распространения является алгоритм обратного распространения ошибки (Back Propagation, BP).

Это алгоритм градиентного спуска, минимизирующий суммарную квадратичную ошибку:

.

.

Здесь индекс i пробегает все выходы многослойной сети.

Основная идея ВР состоит в том, чтобы вычислять чувствительность ошибки сети к изменениям весов. Для этого нужно вычислить частные производные от ошибки по весам. Пусть обучающее множество состоит из Р образцов, и входы k -го образца обозначены через { xik }. Вычисление частных производных осуществляется по правилу цепи: вес входа i -го нейрона, идущего от j -го нейрона, пересчитывается по формуле:

где e – длина шага в направлении, обратном к градиенту.

Если рассмотреть отдельно k -тый образец, то соответствующее изменение весов равно:

Множитель  вычисляется через аналогичные множители из последующего слоя, и ошибка, таким образом, передается в обратном направлении.

вычисляется через аналогичные множители из последующего слоя, и ошибка, таким образом, передается в обратном направлении.

Для выходных элементов получим:

Для скрытых элементов множитель  определяется так:

определяется так:

где индекс h пробегает номера всех нейронов, на которые воздействует i -ый нейрон.

Алгоритм обратного распространения ошибки представлен на рис. 5.6.

|

| Рис. 5.6. Алгоритм обратного распространения ошибки |

Приведем способы обеспечения и ускорения сходимости:

- выбор начальных весов. Цель состоит в том, чтобы найти как можно более хорошее начальное приближение к решению и таким образом сэкономить время обучения и улучшить сходимость. Классический подход к этой проблеме состоит в том, чтобы случайным образом выбрать малые значения для всех весов, чтобы быть уверенным, что ни один из сигмоидных элементов не перенасыщен. Однако это не дает полной гарантии, что такое приближение приведет к глобальному минимуму или уменьшит время сходимости;

- упорядочение данных. Чтобы обучение не двигалось в ложном направлении при обработке задачи классификации или распознавания, но не задачи аппроксимирования временных рядов, данные нужно перемешивать случайным образом. Иначе нейросеть «выучит» последовательность случайно оказавшихся рядом значений как истинное правило, и потом будет делать ошибку;

- импульс. Иногда при изменении весов связей нейронов кроме текущего изменения веса к нему прибавляют вектор смещения с предыдущего шага, взятый с некоторым коэффициентом. В этом случае говорят, что учитывается предыдущий импульс движения;

- управление величиной шага. Величина шага сети e это - мера точности обучения сети. Чем он больше, тем более грубым будет следующее уменьшение суммарной ошибки сети. Чем он меньше, тем больше времени сеть будет тратить на обучение и тем более возможно ее попадание в окрестность локального минимума ошибки. Поэтому управление шагом имеет важное значение для улучшения сходимости нейронной сети;

- оптимизация архитектуры сети. Одной из самых больших проблем при использовании нейросетей является невозможность предварительного определения оптимального количества скрытых слоев и нейронов в них. Если нейронов будет слишком мало, то это равносильно потере каких-то нелинейных связей в модели, если нейронов будет много, то это может привести к «переобучению» сети, то есть она просто «выучит» данные, а не распознает их структуру. Поэтому применяется два основных подхода:

1) деструктивный подход: берется сеть заведомо большего размера, чем нужно, и в процессе обучения из нее удаляются связи и даже сами нейроны;

2) конструктивный подход: первоначально берется маленькая сеть, и к ней, в соответствии со структурой и сложностью задачи, добавляются новые элементы;

- масштабирование данных. При рассмотрении решающих функций внутри нейронов указано, что диапазон выходных значений нейрона лежит в интервале (0, 1) либо (-1, 1). Поэтому для лучшей работы сети следует предварительно масштабировать данные обучающей выборки к интервалу от 0 до 1. Это даст меньшие ошибки при обучении и работе нейросети;

- организация процесса обучения. Из теоремы об отображении практически любой функции с помощью многослойной нейросети следует, что обучаемая нами нейронная сеть в принципе способна сама подстроиться под любые данные с целью минимизации суммарной квадратичной ошибки. Чтобы этого не происходило при обучении нейросетей используют следующий способ проверки сети. Для этого обучающую выборку еще перед началом обучения разбивают случайным образом на две подвыборки: обучающую и тестовую. Обучающую выборку используют собственно для процесса обучения, при этом изменяются веса нейронов. А тестовую используют в процессе обучения для проверки на ней суммарной квадратичной ошибки, но при этом не происходит изменение весов. Если нейросеть показывает улучшение аппроксимации и на обучающей, и на тестовой выборках, то обучение сети происходит в правильном направлении. Иначе может снижаться ошибка на обучающей выборке, но происходить ее увеличение на тестовой. Последнее означает, что сеть «переобучилась» и уже не может быть использована для прогнозирования или классификации. В этом случае немного изменяются веса нейронов, чтобы вывести сеть из окрестности локального минимума ошибки.

Ниже приведен перечень возможных промышленных применений нейронных сетей, на базе которых либо созданы коммерческие продукты, либо реализованы демонстрационные прототипы:

- банки и страховые компании;

- административное обслуживание;

- нефтяная и химическая промышленность;

- военная промышленность и аэронавтика;

- промышленное производство;

- служба безопасности;

- биомедицинская промышленность;

- телевидение и связь.

Функции активации служат для управления силой выходного сигнала для узла (кроме входного слоя, который использует входы непосредственно). Эти функции устанавливают величину выходного сигнала между 0 и 1. Вход в функцию активации – скалярная произведение входных сигналов всего узла и вектора веса узла. «Qnet» дает возможность выбора из двух различных типов передаточных функций: сигмоид и гауссовой.

Рассмотрим четыре вида функции активации, используемых в «Qnet».

Сигмоидная – передаточная функция, используемая в «Qnet» по умолчанию, наиболее широко используемая функция для нейросетей с обратным распространением. Сигмоидная функция представлена математическим отношением  . Кроме того, она обладает свойством усиливать слабые сигналы лучше, чем большие, и предотвращает насыщение от больших сигналов, так как они соответствуют областям аргументов, где сигмоид имеет пологий наклон.

. Кроме того, она обладает свойством усиливать слабые сигналы лучше, чем большие, и предотвращает насыщение от больших сигналов, так как они соответствуют областям аргументов, где сигмоид имеет пологий наклон.

Гауссова передаточная функция может значительно изменять динамику модели нейросети. Сети, основанные на гауссовых функциях активации, имеют тенденцию к более быстрому обучению, чем сигмоидные аналоги, но также и имеют тенденцию, чтобы произвести сети, которые являются склонными к запоминанию и менее годны к употреблению.

Аналоги сигмоидальной и гауссовой функции – гиперболический тангенс и гиперболический секанс. Гиперболический тангенс подобен сигмоидальной кривой, но может проявлять различную динамику изучения в течение обучения. Это может ускорять изучение для некоторых моделей, но это также может привести к меньшей точности, чем у моделей, основанных на сигмоидальных функциях.

Одной из самых больших проблем при использовании нейросетей является невозможность предварительного определения оптимального количества скрытых слоев и нейронов в них. Поэтому применяется два основных подхода:

- деструктивный подход: берется сеть заведомо большего размера, чем нужно, и в процессе обучения из нее удаляются связи и даже сами нейроны;

- конструктивный подход: первоначально берется маленькая сеть, и к ней, в соответствии со структурой и сложностью задачи, добавляются новые элементы.

При обучении нейросетей в «Qnet» используются следующий способ проверки сети. Обучающую выборку еще перед началом обучения разбивают случайным образом на две подвыборки: обучающую и тестовую. Обучающую выборку используют собственно для процесса обучения, при этом изменяются веса нейронов. А тестовую используют в процессе обучения для проверки на ней суммарной квадратичной ошибки, но при этом не происходит изменение весов.

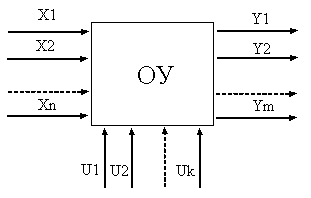

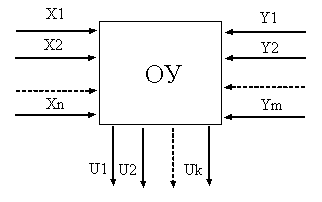

Решение прямой задачи заключается в нахождении выходных величин объекта управления (рис. 5.7) при изменении его входных параметров или управляющих воздействий.

Решение обратной задачи (рис. 5.8) заключается в нахождении управляющих воздействий или входных параметров для получения заданных выходных величин.

|

|

| Рис. 5.7. Блок-схема ОУ | Рис. 5.8. Блок-схема решения обратной задачи |

|

|