Главная страница Случайная страница

Разделы сайта

АвтомобилиАстрономияБиологияГеографияДом и садДругие языкиДругоеИнформатикаИсторияКультураЛитератураЛогикаМатематикаМедицинаМеталлургияМеханикаОбразованиеОхрана трудаПедагогикаПолитикаПравоПсихологияРелигияРиторикаСоциологияСпортСтроительствоТехнологияТуризмФизикаФилософияФинансыХимияЧерчениеЭкологияЭкономикаЭлектроника

Параметры уравнения регрессии и их оценки, необходимые свойства оценок

|

|

Для нахождения параметров а и b уравнения регрессии используют метод наименьших квадратов. При применении метода наименьших квадратов для нахождения такой функции, которая наилучшим образом соответствует эмпирическим данным, считается, что сумма квадратов отклонений эмпирических точек от теоретической линии регрессии должна быть величиной минимальной.

Критерий метода наименьших квадратов можно записать таким образом:

или

Следовательно, применение метода наименьших квадратов для определения параметров a и b прямой, наиболее соответствующей эмпирическим данным, сводится к задаче на экстремум.

Относительно оценок можно сделать следующие выводы:

1. Оценки метода наименьших квадратов являются функциями выборки, что позволяет их легко рассчитывать.

2. Оценки метода наименьших квадратов являются точечными оценками теоретических коэффициентов регрессии.

3. Эмпирическая прямая регрессии обязательно проходит через точку x, y.

4. Эмпирическое уравнение регрессии построено таким образом, что сумма отклонений  .

.

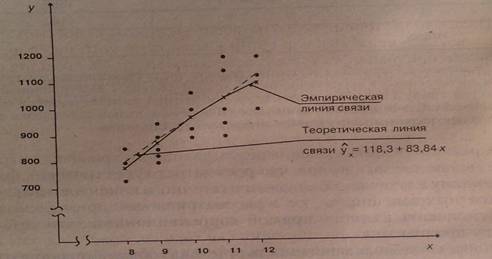

Графическое изображение эмпирической и теоретической линии связи представлено на рисунке 1.

рис. 1.

Параметр b в уравнении – это коэффициент регрессии. При наличии прямой корреляционной зависимости коэффициент регрессии имеет положительное значение, а в случае обратной зависимости коэффициент регрессии – отрицательный. Коэффициент регрессии показывает на сколько в среднем изменяется величина результативного признака «y» при изменении факторного признака «x» на единицу. Геометрически коэффициент регрессии представляет собой наклон прямой линии, изображающей уравнение корреляционной зависимости, относительно оси «x» (для уравнения  ).

).

Наиболее часто для определения формы корреляционной связи используют уравнение прямой

yх=a0+a1х

где ух - теоретические значения результативного признака;

— Регулярная проверка качества ссылок по более чем 100 показателям и ежедневный пересчет показателей качества проекта.

— Все известные форматы ссылок: арендные ссылки, вечные ссылки, публикации (упоминания, мнения, отзывы, статьи, пресс-релизы).

— SeoHammer покажет, где рост или падение, а также запросы, на которые нужно обратить внимание.

SeoHammer еще предоставляет технологию Буст, она ускоряет продвижение в десятки раз, а первые результаты появляются уже в течение первых 7 дней. Зарегистрироваться и Начать продвижение

х - факторный признак;

а0 и а1, - параметры уравнения связи.

Уравнением связи называется уравнение регрессии, а анализ, производимый с помощью уравнения регрессии, называется регрессионным анализом.

После установления вида функции для модели связи определяются параметры уравнения регрессии а0 и а1. Параметры уравнения регрессии определяются методом наименьших квадратов, суть которого состоит в том, что теоретическая линия регрессии должна быть проведена так, чтобы сумма квадратов отклонений эмпирических данных от теоретических была величиной минимальной. Исчисляя первые производные по а0 и а1 от функции Σ (у -а0 –а1х)2 —> min и приравнивая их к нулю, получаем систему нормальных уравнений вида:

| (1.8.6) |

Решая систему нормальных уравнений, определяем параметры а0 и а1:

Параметр а1 называется коэффициентом регрессии и показывает изменения результативного признака при изменении факторного признака на единицу. Параметр а0 не имеет экономического содержания, так как может принимать отрицательные значения.

Очень часто исследуемые признаки имеют разные единицы измерения, поэтому для оценки влияния факторного признака на результативный применяется коэффициент эластичности. Он вычисляется для каждой точки и в среднем для всей совокупности.

Несмещенность оценки означает, что математическое ожидание остатков равно нулю. Если оценки обладают свойством несмещенности, то их можно сравнивать по разным исследованиям.

Оценки считаются эффективными, если они характеризуются наименьшей дисперсией. В практических исследованиях это означает возможность перехода от точечного оценивания к интервальному.

Состоятельность оценок характеризует увеличение их точности с увеличением объема выборки.

16. Понятие о методе наименьших квадратов (= в тетради и в статистике)

МЕТОД НАИМЕНЬШИХ КВАДРАТОВ — математический (математико-статистический) прием, служащий для выравнивания динамических рядов, выявления формы корреляционной связи между случайными величинами и др. Состоит в том, что функция, описывающая данное явление, аппроксимируется более простой функцией. Причем последняя подбирается с таким расчетом, чтобы среднеквадратичное отклонение фактических уровней функции в наблюдаемых точках от выровненных было наименьшим.

Напр., по имеющимся данным (xi, yi) (i = 1, 2,..., n) строится такая кривая y = a + bx, на которой достигается минимум суммы квадратов отклонений

— Разгрузит мастера, специалиста или компанию;

— Позволит гибко управлять расписанием и загрузкой;

— Разошлет оповещения о новых услугах или акциях;

— Позволит принять оплату на карту/кошелек/счет;

— Позволит записываться на групповые и персональные посещения;

— Поможет получить от клиента отзывы о визите к вам;

— Включает в себя сервис чаевых.

Для новых пользователей первый месяц бесплатно. Зарегистрироваться в сервисе

т. е. минимизируется функция, зависящая от двух параметров: a — отрезок на оси ординат и b — наклон прямой.

т. е. минимизируется функция, зависящая от двух параметров: a — отрезок на оси ординат и b — наклон прямой.

Уравнения, дающие необходимые условия минимизации функции S (a, b), называются нормальными уравнениями.

В качестве аппроксимирующих функций применяются не только линейная (выравнивание по прямой линии), но и квадратическая, параболическая, экспоненциальная и др.

Метод наименьших квадратов(МНК, англ. Ordinary Least Squares, OLS) является одним из основных методов определения параметров регрессионных уравнений, Он заключается в том, чтобы определить вид кривой, характер которой в наибольшей степени соответствует выраженной эмпирическими данными зависимости. Такая кривая должна обеспечить наименьшее значение суммы квадратов отклонений эмпирических значений величин показателя от значений, вычисленных согласно уравнению этой кривой. Меняя вид теоретических кривых, приближенно отображающих динамику рассматриваемого показателя, пытаются добиться как можно меньшего значения этой разности.

Сущность обоснования Н. к. м. (по Гауссу) заключается в допущении, что «убыток» от замены точного (неизвестного) значения физической величины и её приближённым значением X, вычисленным по результатам наблюдений, пропорционален квадрату ошибки: (X - μ)2. В этих условиях оптимальной оценкой естественно признать такую лишённую систематической ошибки величину X, для которой среднее значение «убытка» минимально. Именно это требование и составляет основу Н. к. м. В общем случае отыскание оптимальной в смысле Н. к. м. оценки Х — задача весьма сложная, поэтому практически эту задачу сужают и в качестве Х выбирают линейную функцию от результатов наблюдений, лишённую систематической ошибки, и такую, для которой среднее значение «убытка» минимально в классе всех линейных функций. Если случайные ошибки наблюдений подчиняются нормальному распределению (См. Нормальное распределение) и оцениваемая величина μ зависит от средних значений результатов наблюдений линейно (случай, весьма часто встречающийся в приложениях Н. к. м.), то решение этой задачи будет одновременно являться и решением общей задачи. При этом оптимальная оценка Х также подчиняется нормальному распределению со средним значением μ и, следовательно, плотность вероятности случайной величины Х

при х = Х достигает максимума в точке μ = Х (это свойство и выражает точное содержание распространённого в теории ошибок утверждения «оценка X, вычисленная согласно Н. к. м., — наиболее вероятное значение неизвестного параметра μ»).

|

|