Главная страница Случайная страница

Разделы сайта

АвтомобилиАстрономияБиологияГеографияДом и садДругие языкиДругоеИнформатикаИсторияКультураЛитератураЛогикаМатематикаМедицинаМеталлургияМеханикаОбразованиеОхрана трудаПедагогикаПолитикаПравоПсихологияРелигияРиторикаСоциологияСпортСтроительствоТехнологияТуризмФизикаФилософияФинансыХимияЧерчениеЭкологияЭкономикаЭлектроника

ХИЗМ-ХД.

|

|

Относительная погрешность — погрешность СИ, выраженная отношением абсолютной погрешности средства измерений к результату измерений или к действительному значению измеренной физической величины:

γ отн = (Δ /Хд)100.

Для измерительного прибора γ отн характеризует погрешность в данной точке шкалы, зависит от значения измеряемой величины и имеет наименьшее значение вконце шкалы прибора.

Для характеристики точности многих средств измерений применяется приведенная погрешность.

Приведенная погрешность — относительная погрешность, выраженная отношением абсолютной погрешности СИ к условно принятому значению величины, постоянному во всем диапазоне измерений или в части диапазона:

γ прив = (Δ /Хнорм)100,

где Хнорм — нормирующее значение, т.е. некоторое установленное значение, по отношению к которому рассчитывается погрешность.

Выбор нормирующего значения производится в соответствии с ГОСТ 8.009 — 84. Это может быть верхний предел измерений СИ, диапазон измерений, длина шкалы и т.д. Для многих средств измерений по приведенной погрешности устанавливают класс точности прибора.

По причине и условиям возникновения погрешности средств измерений подразделяются на основную и дополнительную.

Основная погрешность — это погрешность СИ, находящихся в нормальных условиях эксплуатации. Она возникает из-за неидеальности собственных свойств СИ и показывает отличие действительной функции преобразования СИ в нормальных условиях от номинальной.

Нормативными документами на СИ конкретного типа (стандартами, техническими условиями, калибровкой и др.) оговариваются нормальные условия измерений — это условия измерения, характеризуемые совокупностью значений или областей значений влияющих величин, при которых изменением результата измерений пренебрегают вследствие малости. Среди таких влияющих величин наиболее общими являются температура и влажность окружающей среды, напряжение, частота и форма кривой питающего напряжения, наличие внешних электрических и магнитных полей и др. Для нормальных условий применения СИ нормативными документами предусматриваются:

нормальная область значений влияющей величины (диапазон значений): температура окружающей среды — (20 ± 5) °С; положение прибора — горизонтальное с отклонением от горизонтального ±2°; относительная влажность — (65 ± 15) %; практическое отсутствие электрических и магнитных полей, напряжение питающей сети — (220±4, 4) В, частота питающей сети — (50± 1) Гц и т.д.;

рабочая область значений влияющей величины — область значений влияющей величины, в пределах которой нормируют дополнительную погрешность или изменение показаний средства измерений;

рабочие условия измерений — это условия измерений, при которых значения влияющих величин находятся в пределах рабочих областей. Например, для измерительного конденсатора нормируют дополнительную погрешность на отклонение температуры окружающего воздуха от нормальной; для амперметра — изменение показаний, вызванное отклонением частоты переменного тока от 50 Гц (значение частоты 50 Гц в данном случае принимают за нормальное значение частоты).

Дополнительная погрешность — составляющая погрешности СИ, возникающая дополнительно к основной погрешности вследствие отклонения какой-либо из влияющих величин от нормального ее значения или вследствие ее выхода за пределы нормальной области значений. Нормируются, как правило, значения основной и дополнительной погрешностей, рассматриваемые как наибольшие для данного средства измерений.

Предел допускаемой основной погрешности — наибольшая основная погрешность, при которой СИ может быть признано годным и допущено к применению по техническим условиям.

Предел допускаемой дополнительной погрешности — это та наибольшая дополнительная погрешность, при которой средство измерения может быть допущено к применению. Например, для прибора класса точности 1, 0 приведенная дополнительная погрешность при изменении температуры на 10 °С не должна превышать ±1 %. Это означает, что при изменении температуры среды на каждые 10 °С добавляется дополнительная погрешность 1 %.

Пределы допускаемых основной и дополнительной погрешностей выражают в форме абсолютных, относительных и приведенных погрешностей.

Обобщенная характеристика данного типа средств измерений, как правило, отражающая уровень их точности, определяемая пределами допускаемых основной и дополнительных погрешностей, а также другими характеристиками, влияющими на точность, называется классом точности СИ. Класс точности дает возможность судить о том, в каких пределах находится погрешность СИ одного типа, но не является непосредственным показателем точности измерений, выполняемых с помощью каждого из этих средств, так как погрешность зависит также от метода измерений, условий измерений и т.д. Это важно учитывать при выборе СИ в зависимости от заданной точности измерений. Класс точности СИ конкретного типа устанавливают в стандартах технических требований (условий) или в других нормативных документах. Например, прибор класса 0, 5 может иметь основную приведенную погрешность, непревышающую 0, 5 %. Вместе с тем прибор должен удовлетворять соответствующим требованиям и в отношении допускаемых дополнительных погрешностей. Например, ГОСТ 8.401 — 80 устанавливает девять классов точности для аналоговых электромеханических приборов: 0, 05; 0, 1; 0, 2; 0, 5; 1, 0; 1, 5; 2, 5; 4, 0; 6, 0.

Зная класс точности СИ, можно найти максимально допустимое значение абсолютной погрешности для всех точек диапазона:

Δ mах доп = γ привXнорм / 100.

По характеру изменения погрешности средств измерений подразделяются на систематические, случайные и промахи.

Систематические погрешности Δ с — составляющие погрешности измерений, сохраняющиеся постоянными или закономерно изменяющиеся при многократных измерениях величины в одних и тех же условиях. Такие погрешности выявляют детальным анализом их возможных источников и уменьшают введением соответствующей поправки, применением более точных приборов, калибровкой приборов с помощью рабочих мер и т. п. Систематическая погрешность данного средства измерений, как правило, будет отличаться от систематической погрешности другого экземпляра средства измерений этого же типа, из-за чего для группы однотипных средств измерений систематическая погрешность может иногда рассматриваться как случайная погрешность.

Случайные погрешности Δ сл — составляющие погрешности измерений, зависящие от большого количества непредсказуемых факторов и изменяющиеся случайным образом по значению и знаку при повторных измерениях одной и той же физической величины в одних и тех же условиях. Данные погрешности проявляются при повторных измерениях одной и той же физической величины в виде некоторого разброса получаемых результатов. Описание и оценка случайных погрешностей возможны только на основе теории вероятностей и математической статистики.

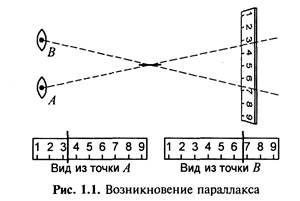

К случайным погрешностям можно отнести погрешность считывания показаний. Основную роль здесь играют параллакс и ошибки интерполяции. Параллакс — это кажущееся смещение рассматриваемого предмета из-за перемещения глаза наблюдателя (рис. 1.1).

|

Интерполяция — способ нахождения промежуточных значений величины по имеющемуся дискретному набору известных значений. Если стрелка измерительного устройства не попадает точно на деление шкалы, оператору для снятия отсчета приходится прибегать к интерполяции. При визировании из точки А отсчет может быть 3, 3 либо 3, 4, а при визировании из точки В возможны значения 6, 7 либо 6, 8.

Экспериментально установлено, что приведенная погрешность считывания показаний у щитовых электроизмерительных приборов классов 1; 2, 5 и 4 составляет 0, 45...0, 6 %, а у образцовых лабораторных электроизмерительных приборов классов 0, 2 и 0, 5 составляет 0, 1...0, 12 %. Уменьшение погрешности считывания показаний у образцовых стрелочных приборов достигается за счет применения противопараллаксных устройств и увеличения количества промежуточных делений (у цифровых приборов погрешность считывания показаний практически отсутствует).

Общее выражение для вычисления погрешности считывания показаний: Δ = Δ 3 + Δ п + Δ и, где Δ 3 — погрешность из-за ограниченной разрешающей способности зрения; Δ п — погрешность от параллакса; Δ и — погрешность интерполяции.

При этом; Δ 3 = 0, 07(Хк/l), где Хк — конечное значение шкалы прибора в единицах измеряемой величины; l — длина шкалы, мм; Δ п = 0, 055 (Хк/l); Δ и = 0, 1α, где α — цена деления шкалы.

Подставив эти значения, получим

Δ = 0, 07(Хк / l) + 0, 055(Хк/l) + 0, 1 α = 0, 125(Хк/l) + 0, 1 α.

В табл. 1.4 приведены данные по конкретным приборам М4202 класса 1, 5, поверяемым приборами типа М2015 класса 0, 2.

Таблица 1.4

| Вид погрешности | Значение погрешности | |

| Миллиамперметр М4204 класса 1, 5 0—30 мА, цена деления 1 мА | Миллиамперметр М2015 класса 0, 2 0—30 мА, цена деления 0, 2 мА | |

| Абсолютная погрешность из-за ограниченной разрешающей способности зрения Δ 3, мА | +0, 042 | ±0, 015 |

| Абсолютная погрешность от параллакса Δ п, мА | ±0, 033 | |

| Абсолютная погрешность интерполяции Δ и, мА | ±0, 1 | +0, 02 |

| Абсолютная погрешность считывания показаний Δ, мА | ±0, 175 | ±0, 035 |

| Приведенная погрешность считывания показаний δ, % | ±0, 583 | ±0, 117 |

Оценим соотношение субъективных погрешностей считывания показаний при поверке методом сличения этих приборов, пользуясь данными таблицы. Погрешность считывания показаний для щитового прибора типа М4202 в 4, 9 раза больше, чем для образцового прибора типа М2015. Наибольшая составляющая субъективной погрешности считывания показаний — погрешность интерполяции.

Промахи — грубые погрешности, связанные с ошибками оператора или неучтенными внешними воздействиями. Их обычно исключают из результатов измерений.

По зависимости от значения измеряемой величины погрешности СИ подразделяются на аддитивные, не зависящие от значения входной величины X, и мультипликативные — пропорциональные X.

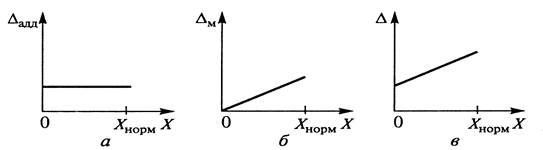

Аддитивная погрешность Δ АДД не зависит от чувствительности прибора и является постоянной по величине для всех значений входной величины Х в пределах диапазона измерений (рис. 1.1, а). Источники данной погрешности: трение в опорах, шумы, наводки, вибрации. Примерами аддитивной погрешности приборов являются погрешности нуля, погрешность дискретности (квантования) в цифровых приборах. От значения этой погрешности зависит наименьшее значение входной величины. Если прибору присуща только аддитивная погрешность или она существенно превышает другие составляющие, то предел допустимой основной погрешности нормируют в виде приведенной погрешности.

Мультипликативная погрешность зависит от чувствительности прибора и изменяется пропорционально текущему значению входной величины (рис. 1.1, б). Источником этой погрешности являются: погрешности регулировки отдельных элементов СИ (например, шунта и добавочного резистора), старение элементов, изменение их характеристик, влияние внешних факторов.

|

Рис. 1.1. Графики погрешностей измерительных приборов и преобразователей:

а — аддитивной; б — мультипликативной; в — суммарной

Если прибору присуща только мультипликативная погрешность или она существенна, то предел допускаемой относительной погрешности выражают в виде относительной погрешности. Класс точности таких СИ обозначают одним числом, помещенным в кружок и равным пределу допускаемой относительной погрешности, например счетчик электрической энергии класса 2, 5.

Если прибору присуща только мультипликативная погрешность или она существенна, то предел допускаемой относительной погрешности выражают в виде относительной погрешности. Класс точности таких СИ обозначают одним числом, помещенным в кружок и равным пределу допускаемой относительной погрешности, например счетчик электрической энергии класса 2, 5.

Суммарная абсолютная погрешность (рис. 1.1, в) определяется по формуле:

Δ = Δ адд + Δ М = γ адд Хнорм + γ мХ,

где γ адд = Δ адд/ Х норм — приведенное значение аддитивной погрешности; γ M = Δ м/Х — относительное значение мультипликативной погрешности.

Аддитивная и мультипликативная погрешности имеют систематические и случайные составляющие.

Погрешность СИ также может быть нормирована к длине шкалы. В этом случае класс точности обозначается одним числом в процентах, помещенным между двумя линиями, расположенными под углом, например: 0, 5 . К ним относятся показывающие приборы с резко неравномерной шкалой (например, гиперболической или логарифмической). Конкретные ряды классов точности устанавливаются в стандартах на отдельные виды СИ.

Погрешность СИ также может быть нормирована к длине шкалы. В этом случае класс точности обозначается одним числом в процентах, помещенным между двумя линиями, расположенными под углом, например: 0, 5 . К ним относятся показывающие приборы с резко неравномерной шкалой (например, гиперболической или логарифмической). Конкретные ряды классов точности устанавливаются в стандартах на отдельные виды СИ.

В зависимости от влияния характера изменения измеряемой величины погрешности СИ подразделяются на статические и динамические.

Статическая погрешность — погрешность СИ, применяемого при измерении физической величины, принимаемой за неизменную.

Динамическая погрешность — погрешность СИ, возникающая при измерении изменяющейся (в процессе измерений) физической величины, являющаяся следствием инерционных свойств СИ.

|

|