Главная страница Случайная страница

Разделы сайта

АвтомобилиАстрономияБиологияГеографияДом и садДругие языкиДругоеИнформатикаИсторияКультураЛитератураЛогикаМатематикаМедицинаМеталлургияМеханикаОбразованиеОхрана трудаПедагогикаПолитикаПравоПсихологияРелигияРиторикаСоциологияСпортСтроительствоТехнологияТуризмФизикаФилософияФинансыХимияЧерчениеЭкологияЭкономикаЭлектроника

Количественная мера информации.

|

|

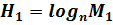

При введении понятия энтропии мы исходили из количества событий, о которых нам необходимо получить информацию. Таким образом, энтропия характеризует количество информации, получаемой путём исследования интересующего нас процесса, если мы можем получить в своё распоряжение сведения о любом из M интересующих нас событий. Однако возможен такой исход исследования (или измерений), когда о некоторых событиях из рассматриваемых М событий сведения фактически не будут получены. Допустим, что до проведения исследований предусматривалась реализация одного из  событий, но осталось невыясненным, какое именно из этих

событий, но осталось невыясненным, какое именно из этих  событий реализовано в действительности. Энтропия исследуемого процесса до проведения исследований могла достичь значения:

событий реализовано в действительности. Энтропия исследуемого процесса до проведения исследований могла достичь значения:

,

,

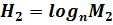

а после проведения исследований она уменьшилась до значения, не превышающего:

.

.

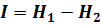

В таком случае количество I полученной информации определяется разностью между исходной и конечной энтропиями:

. (2.5)

. (2.5)

Формула (2.5) даёт обобщённую количественную оценку информации и соответствует формулировке: количество информации равно убыли энтропии. Величина исчерпывающей информации соответствует  и равна исходной энтропии.

и равна исходной энтропии.

В качестве примера рассмотрим оценку количества информации, получаемой от аналогового измерительного прибора с длиной рабочей части шкалы, равной L, работающего с погрешностью ∆, заданной в единицах длины прибора.

Предположим, что допустимая погрешность δ в заданной измерительной системе меньше той, которую может обеспечить используемый прибор: δ < ∆. Исходя из заданной точности измерений прибор должен гарантировать  точек измерения.

точек измерения.

Начальная энтропия измерений:

,

,

а энтропия после измерений:

.

.

Количество информации, получаемой от этого прибора:

=

=  ,

,

т.е. определяется его точностью во всех случаях, когда имеет место δ < ∆. При δ = ∆ величина  . Это свидетельствует о том, что измерения производятся с заданной точностью. Заданная точность измерений поддерживается и при δ > ∆, т.е. сохраняется равенство

. Это свидетельствует о том, что измерения производятся с заданной точностью. Заданная точность измерений поддерживается и при δ > ∆, т.е. сохраняется равенство  . Хотя измерительный прибор при δ > ∆ может обеспечить точность измерений больше заданной, это обстоятельство не является определяющим. Ведь величина исчерпывающей информации равна исходной энтропии, на которую сориентирована работа всего измерительного и управляющего комплекса, а точность первичного прибора является лишь одним из многих факторов, определяющих точность измерений. Иными словами, информация будет фиксироваться и преобразовываться в соответствии с принятым объёмом энтропии, а повышенная точность отдельных звеньев измерительного комплекса не будет учитываться.

. Хотя измерительный прибор при δ > ∆ может обеспечить точность измерений больше заданной, это обстоятельство не является определяющим. Ведь величина исчерпывающей информации равна исходной энтропии, на которую сориентирована работа всего измерительного и управляющего комплекса, а точность первичного прибора является лишь одним из многих факторов, определяющих точность измерений. Иными словами, информация будет фиксироваться и преобразовываться в соответствии с принятым объёмом энтропии, а повышенная точность отдельных звеньев измерительного комплекса не будет учитываться.

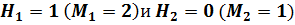

Для практических расчётов количество информации по формулам (2.1), (2.2), (2.3) и (2.5) введём понятие единицы измерения информации. Примем во внимание, что в устройствах хранения, передачи и переработки информации обычно применяются элементы, в которых для записи информации используется только два символа, такие как высокий и низкий потенциалы (в электронных устройствах) или намагниченный и не намагниченный участки магнитных носителей информации. В качестве этих символов обычно используют 1 и 0. Использование только этих символов для записи информации соответствует  в формулах (2.1), (2.2), (2.3) (в дальнейших рассуждениях мы так и будем полагать). Тогда при исследовании процесса с двумя равновероятными исходами в соответствии с формулой (2.1) получаем:

в формулах (2.1), (2.2), (2.3) (в дальнейших рассуждениях мы так и будем полагать). Тогда при исследовании процесса с двумя равновероятными исходами в соответствии с формулой (2.1) получаем:  , что в соответствии с формулой (2.5) даёт информацию I = 1.

, что в соответствии с формулой (2.5) даёт информацию I = 1.

Информацию, которую получают из опыта с двумя равновероятными исходами, используют в качестве эталона (единицы) количества информации в устройствах, в которых запись информации производится только с помощью двух символов. Эту информацию называют битом, или двоичной единицей информации. Согласно формуле (2.3) количество информации, равное одному биту, можно получить и иным путём, из опыта со многими, но не равновероятными исходами. Опыт с двумя равновероятными исходами (к которому приближается, например, подбрасывание монеты) является лишь эталоном бита.

Из определения бита следует, что максимальное количество информации, которая может храниться в электронном триггере или на элементарном намагниченном участке магнитной дискеты, равному одному биту. По тем же причинам номинальная ёмкость ЗУ, указанная в битах, есть максимальное количество информации, которое может храниться в этих ЗУ при условии, что все события, сообщения о которых зафиксированы в ЗУ, являются равновероятными. Обычно в ЗУ зафиксированы сообщения о событиях, которые не равновероятны. Ярким примером такого рода сообщений являются сообщения об отсутствии аварийной ситуации. Их вероятность при нормальном ходе технологического процесса значительно выше вероятности поступления сигнала аварии. По указанным причинам фактический объём информации, хранящейся в ЗУ, значительно меньше номинального.

Широко используются производные от бита единицы информации: 1 байт = 8 бит; 1 Кбайт = 210 байт; 1 Мбайт = 220 байт и др.

Особой единицей информации является слово. Слово – это количество информации, обрабатываемой в данном управляющем устройстве за один цикл работы устройства. Величина слова обычно кратна байту: 1 байт, 2 байт, 4 байт. Если необходимо оценить лишь объём записи информации на электронных или магнитных носителях, то битом называют минимальный объём записи, соответствующий двоичной или двоичному нулю (элементарная ячейка памяти).

|

|