Главная страница Случайная страница

Разделы сайта

АвтомобилиАстрономияБиологияГеографияДом и садДругие языкиДругоеИнформатикаИсторияКультураЛитератураЛогикаМатематикаМедицинаМеталлургияМеханикаОбразованиеОхрана трудаПедагогикаПолитикаПравоПсихологияРелигияРиторикаСоциологияСпортСтроительствоТехнологияТуризмФизикаФилософияФинансыХимияЧерчениеЭкологияЭкономикаЭлектроника

Алгоритм обратного распространения ошибки

|

|

0. Начальные значения весов всей нейронов всех слоев полагаются случайными величинами;

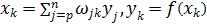

1. На вход подается вх. образ  . На выходе формируются

. На выходе формируются  . Нейроны последовательно от слоя к слою функционируют по следующим формулам:

. Нейроны последовательно от слоя к слою функционируют по следующим формулам:

- выходной сигнал скрытого слоя

- выходной сигнал скрытого слоя

- выходной сигнал,

- выходной сигнал,  - сигмоидальная функция.

- сигмоидальная функция.

2.  - функция ошибки;

- функция ошибки;

Градиентный метод оптимизации состоит в итерационном уточнении аргумента согласно формуле:

Функция ошибки Е в явном виде не содержит зависимости от  . Поэтому воспользуемся формулой неявного дифференцирования сложной функции:

. Поэтому воспользуемся формулой неявного дифференцирования сложной функции:

3. Выполняется подстройка весов открытого слоя:

При вычислении  был применен принцип обратного распространения ошибки, т.е. частные производные берутся только по переменным последующего слоя. По полученным формулами модифицируется веса нейронов скрытого слоя. Если скрытых слоев несколько, то процедура обратного распространения последовательно применяется для каждого из них, начиная со слоя, предшествующего выходному до слоя, стоящего за входным.

был применен принцип обратного распространения ошибки, т.е. частные производные берутся только по переменным последующего слоя. По полученным формулами модифицируется веса нейронов скрытого слоя. Если скрытых слоев несколько, то процедура обратного распространения последовательно применяется для каждого из них, начиная со слоя, предшествующего выходному до слоя, стоящего за входным.

4. Шаги 1-3 повторяются для всех обучающих векторов. Общение завершается по достижении малой полной ошибки или максимально допустимого числа итераций.

|

|